Cos'è Sora? Un modello AI da testo a video?

Alleniamo l’IA a comprendere e replicare la dinamica del mondo fisico, puntando a sviluppare modelli che aiutino ad affrontare problemi che richiedono coinvolgimento reale.

Questo modello IA, il cui nome deriva dal giapponese "cielo", crea video realistici e creativi da descrizioni testuali.

Alleniamo l’IA a comprendere e replicare la dinamica del mondo fisico, puntando a sviluppare modelli che aiutino ad affrontare problemi che richiedono coinvolgimento reale.

Oggi segna una pietra miliare mentre Sora si presenta al pubblico, allargandosi ai "red teamers" per individuare rischi e vulnerabilità. Ma non solo: invitiamo esperti visivi, designer e narratori cinematografici a contribuire alla crescita di Sora, per farne uno strumento indispensabile per i professionisti creativi.

Aprendo le porte alla nostra ricerca anticipatamente, non solo invitiamo alla collaborazione: favoriamo uno scambio vivace di idee con individui esterni a OpenAI. Non è solo presentare le ultime potenzialità AI: è accendere l’immaginazione e mostrare quanto può offrire il futuro.

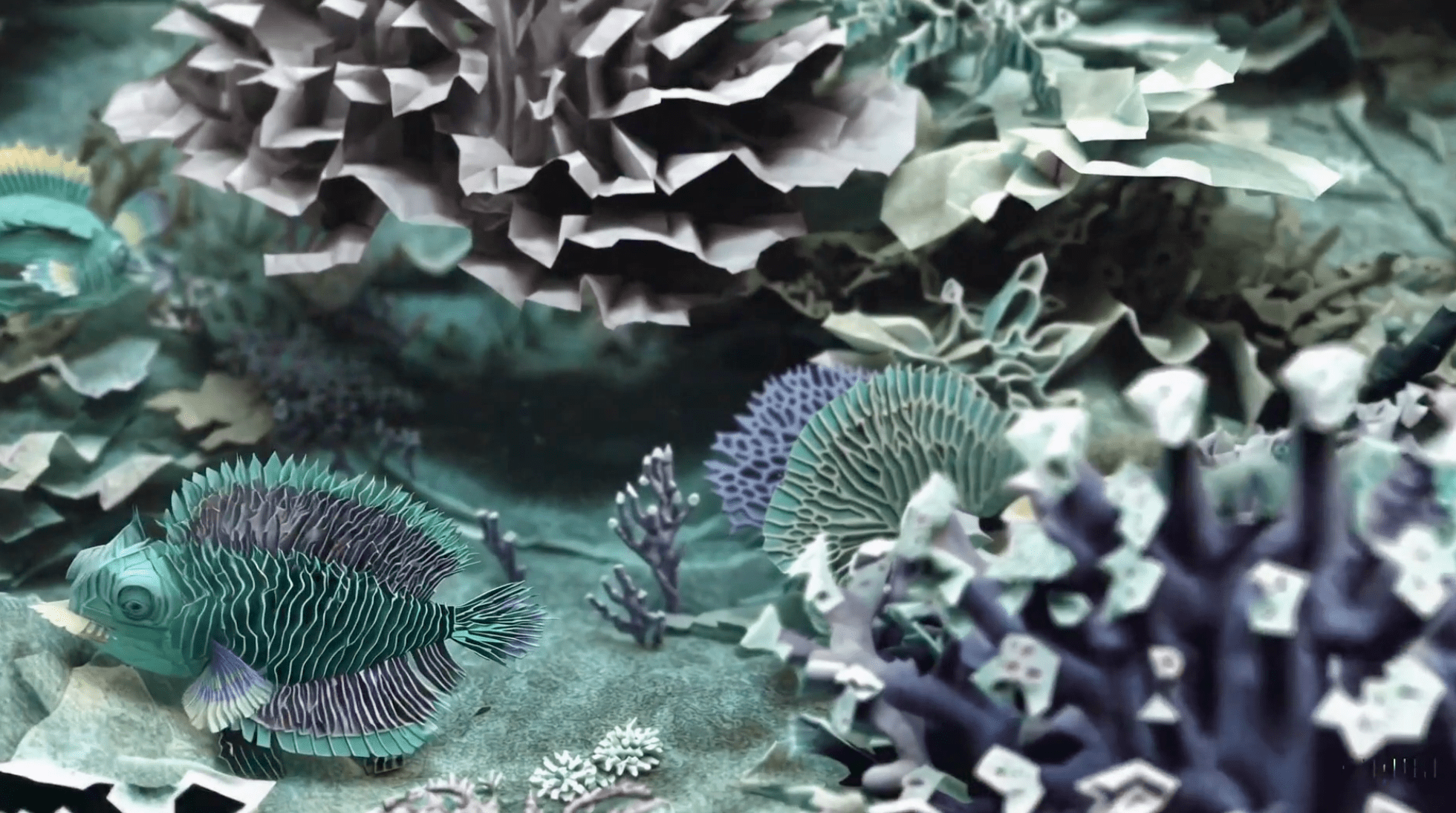

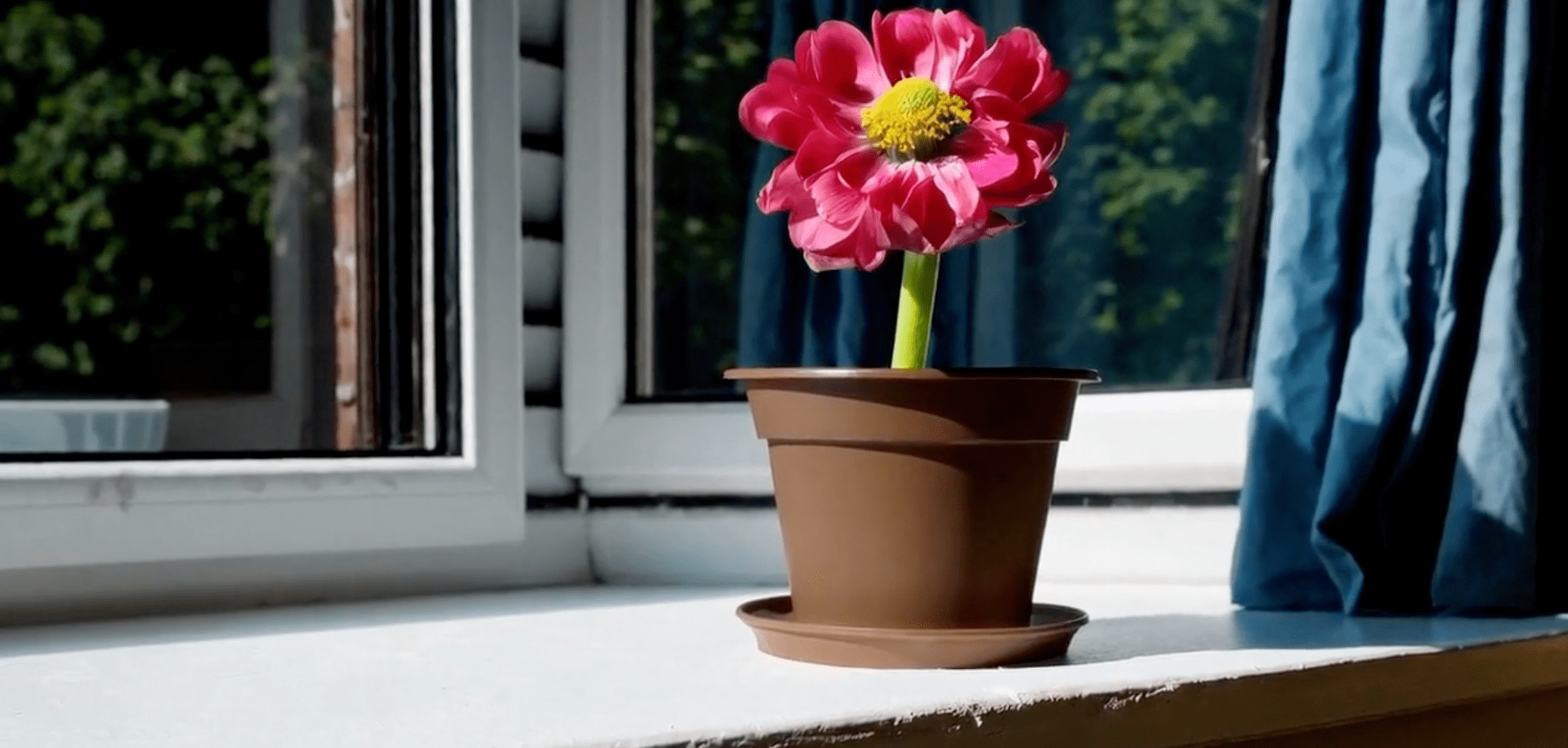

Sora è in grado di creare scene complesse con più personaggi, diversi pattern di movimento e dettagli precisi sia dei soggetti che degli sfondi. Oltre a interpretare i prompt, il modello comprende le sfumature degli elementi nel mondo reale, assicurando un livello di realismo senza precedenti.

Grazie alla profonda comprensione del linguaggio, il modello interpreta facilmente i prompt e crea personaggi vividi e pieni di emozioni. Sora può anche fondere più inquadrature in un unico video, mantenendo costanti aspetto e stile.

Il modello attuale ha però alcune limitazioni. Può avere difficoltà a simulare fisica complessa o trascurare le relazioni causa-effetto. Ad esempio, potrebbe mostrare una persona che morde un biscotto ma non il segno del morso nei fotogrammi successivi.

Anche l’orientamento spaziale nei prompt può creare confusione tra destra e sinistra. Inoltre, il modello può faticare a descrivere correttamente eventi che si svolgono nel tempo, come la traiettoria della telecamera.

Sora usa un modello di diffusione, perfezionando i video da rumore statico. Prevede più fotogrammi garantendo coerenza. Utilizza un’architettura a trasformatori come i modelli GPT, rappresentando i dati visivi a patch. Integra il recaptioning di DALL·E 3 per interpretare fedelmente le istruzioni utente. Sora può generare video da testo, animare immagini statiche ed estendere video esistenti. Questo modello fondativo è un passo verso la comprensione e simulazione del mondo reale, fondamentale verso la vera Intelligenza Artificiale Generale (AGI). Scopri di più qui: https://openai.com/sora

Sfortunatamente, ad oggi (16 febbraio 2024) il modello testo-a-video Sora di OpenAI non è disponibile pubblicamente. Attualmente OpenAI lo usa internamente per ricerca e test, senza data precisa di rilascio per il pubblico.

Accesso limitato: OpenAI inizialmente ha condiviso Sora con "red teamers" (esperti su disinformazione e bias) e alcuni creativi selezionati per ricevere feedback.

Disponibilità futura: OpenAI aggiornerà i progressi e forse fornirà accesso pubblico, ma non ci sono piani concreti annunciati.

Alternative: Esistono opzioni che generano immagini o semplici animazioni da testo, come Dream by WOMBO, NightCafe Creator e DALL-E 2 (accesso limitato). Tuttavia, non permettono ancora di creare veri video come Sora. Anche se ora non è possibile usare direttamente Sora puoi:

Rimanere aggiornato: Segui blog e social OpenAI per le novità su Sora. Esplora alternative: prova strumenti testo-immagine citati sopra per familiarizzare con la tecnologia. Approfondisci: leggi articoli e guarda video sulle capacità e sul potenziale di Sora (vedi link condivisi). Spero che ora la situazione sia più chiara. Anche se ancora non si può usare, è entusiasmante seguirne lo sviluppo futuro.