Sora là gì? Một mô hình AI chuyển văn bản thành video?

Chúng tôi đang huấn luyện AI hiểu và mô phỏng động lực vật lý thế giới thực, để tạo ra những mô hình giúp mọi người giải quyết thách thức cần tương tác với thế giới hiện thực.

Mô hình AI này, lấy tên từ tiếng Nhật nghĩa là 'bầu trời', có thể tạo video sống động, đầy sáng tạo từ văn bản mô tả.

Chúng tôi đang huấn luyện AI hiểu và mô phỏng động lực vật lý thế giới thực, để tạo ra những mô hình giúp mọi người giải quyết thách thức cần tương tác với thế giới hiện thực.

Hôm nay là dấu mốc quan trọng khi Sora bước ra ánh sáng, mở rộng cho red teamers xác định rủi ro trong các lĩnh vực quan trọng. Ngoài ra, chúng tôi còn mời các nhà thiết kế, nhà làm phim tham gia định hướng cho Sora, cam kết biến nó thành công cụ thiết yếu cho dân sáng tạo.

Việc công bố nghiên cứu sớm cũng là lời mời hợp tác; chúng tôi mong muốn trao đổi ý tưởng rộng rãi với những người bên ngoài OpenAI. Đây không chỉ là trình diễn công nghệ AI mới nhất mà còn là nguồn cảm hứng cho những khả năng phía trước.

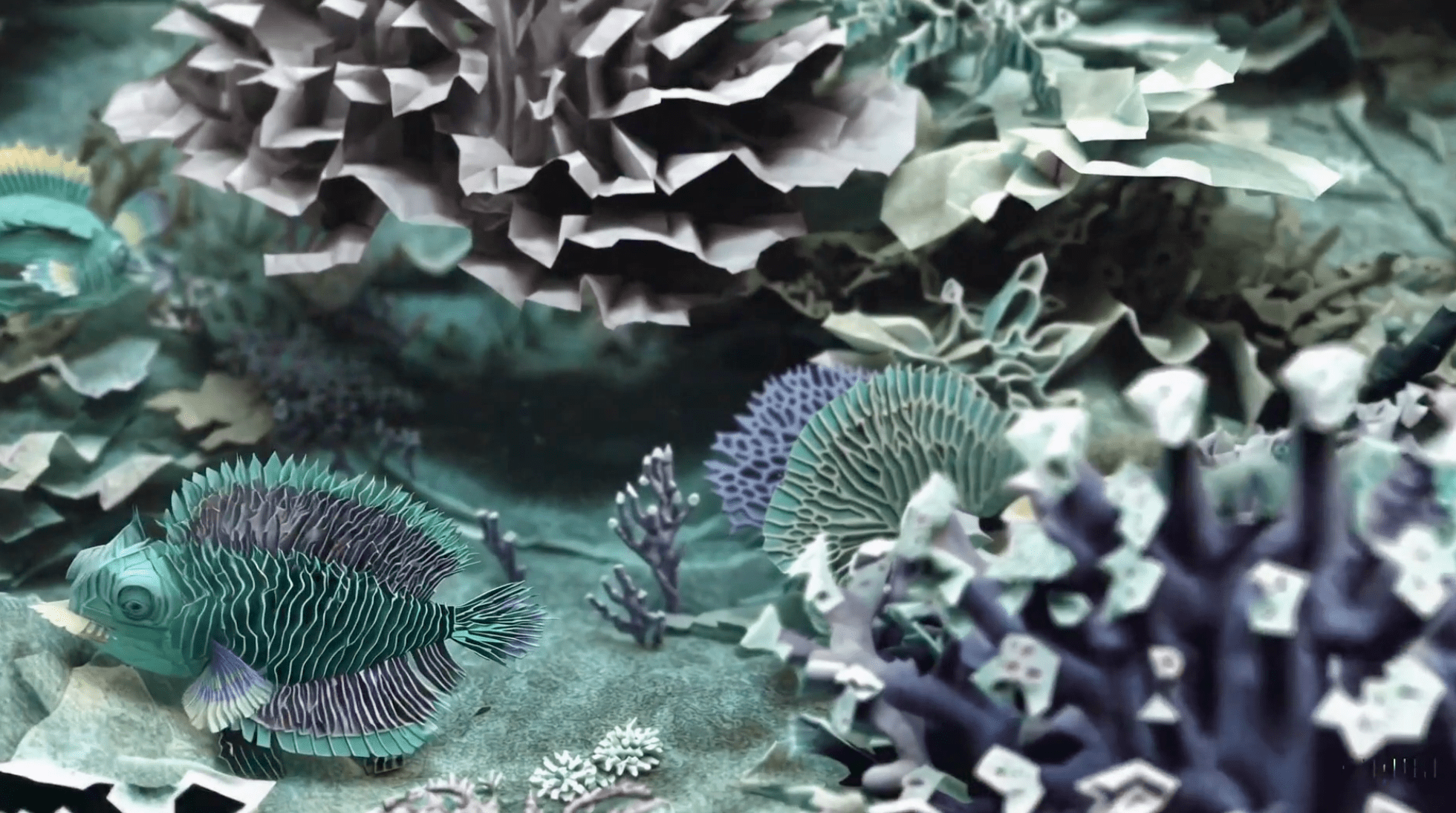

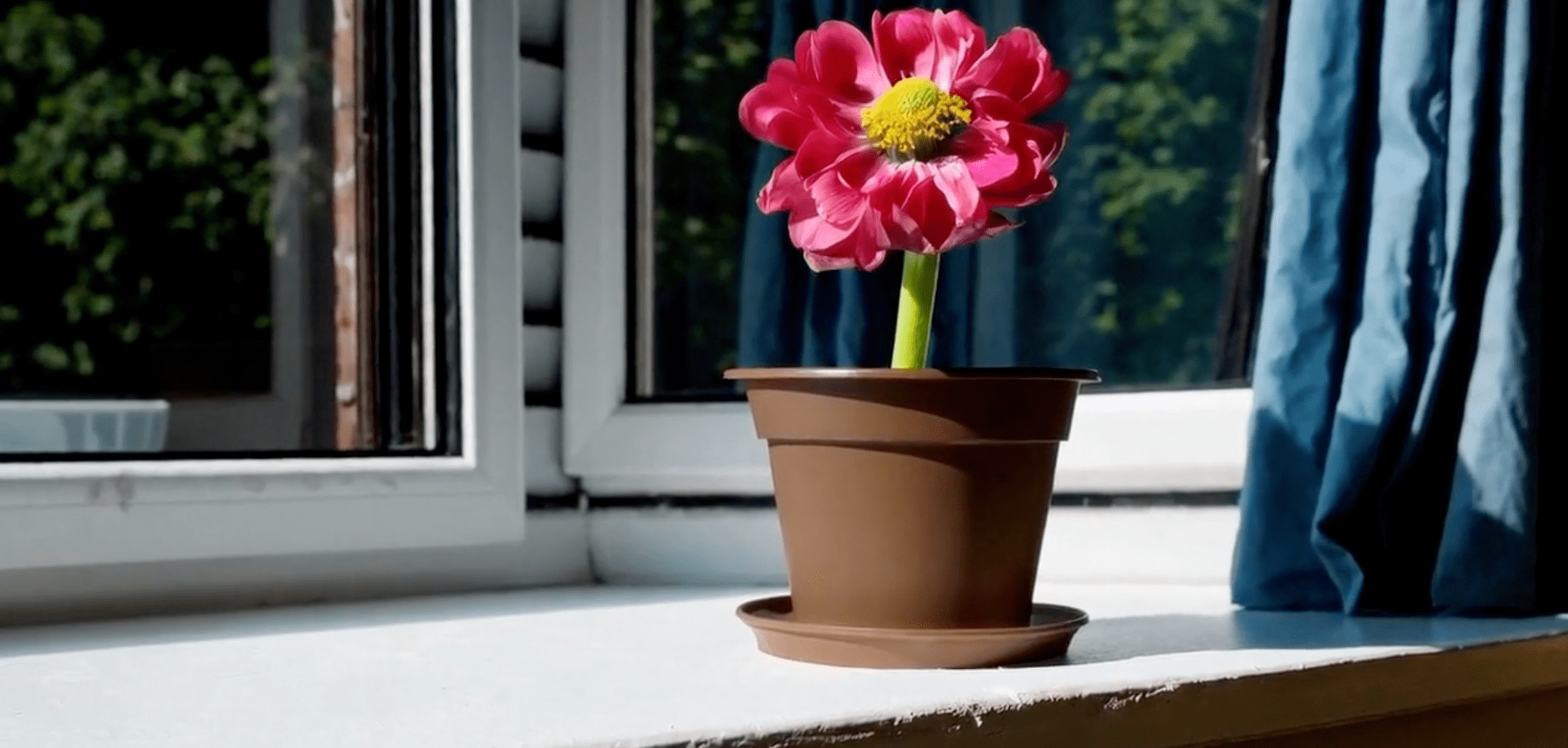

Sora có thể tạo ra các khung cảnh phức tạp với nhiều nhân vật, chuyển động đa dạng, chi tiết chủ thể và hậu cảnh chính xác. Mô hình không chỉ diễn giải prompt mà còn hiểu các yếu tố xuất hiện trong thực tế, mang đến sự chân thực vượt trội.

Nhờ hiểu ngôn ngữ sâu sắc, Sora tạo ra các nhân vật ấn tượng, cảm xúc sinh động. Khả năng của Sora còn vượt ra ngoài, kết hợp nhiều cảnh trong một video, đảm bảo tính nhất quán về nhân vật và thẩm mỹ hình ảnh.

Mô hình hiện tại còn một số hạn chế: việc mô phỏng vật lý phức tạp chưa hoàn hảo và có thể bỏ qua quan hệ nhân-quả. Ví dụ, có người ăn bánh quy trong video nhưng bánh đôi khi không có dấu cắn.

Ngoài ra, định hướng không gian trong prompt (trái, phải) vẫn có thể gây nhầm lẫn hoặc chưa mô tả chính xác sự kiện phức tạp như chuyển động máy quay theo thời gian.

Sora sử dụng mô hình diffusion, tinh chỉnh video từ 'nhiễu trắng'. Mô hình dự đoán nhiều khung hình, đảm bảo chủ thể ổn định. Sora dùng kiến trúc transformer giống GPT và biểu diễn dữ liệu hình ảnh theo 'miếng ghép' như patch, giúp mở rộng tốt. Có tích hợp tính năng recaption từ DALL-E 3 để giải thích prompt người dùng tốt hơn. Sora có thể sinh video từ văn bản, làm sinh động ảnh tĩnh chính xác, kéo dài video. Đây là bước quan trọng hướng tới AGI. Xem thêm tại: https://openai.com/sora

Đáng tiếc, đến 16/2/2024, Sora của OpenAI chưa mở công khai. Hiện chỉ dùng cho nghiên cứu nội bộ, chưa có lịch phát hành rộng rãi.

Truy cập giới hạn: OpenAI ban đầu chỉ cung cấp cho 'red teamers' (chuyên gia kiểm tra lạm dụng, sai lệch) và một nhóm sáng tạo được chọn.

Tương lai: OpenAI sẽ liên tục cập nhật tiến độ và có thể chia sẻ truy cập trong tương lai – nhưng chưa có kế hoạch cụ thể nào.

Các lựa chọn thay thế: Một số công cụ text-to-image, animation như WOMBO Dream, NightCafe Creator, DALL-E 2 (giới hạn) đã có; nhưng chưa tạo được video hoàn chỉnh như Sora. Nếu chưa thể dùng trực tiếp Sora, bạn có thể:

Theo dõi: Cập nhật blog, mạng xã hội OpenAI để biết thông tin Sora; Thử nghiệm công cụ thay thế kể trên để làm quen công nghệ; Đọc tin, xem video về tiềm năng của Sora. Hi vọng bạn đã rõ tình hình Sora hiện tại. Dù chưa thể dùng, nhưng sự phát triển của nó vẫn rất đáng mong đợi.